少し前からDeepseekの名前は見かけていましたが、先日の発表から一気に広がりましたね。

というわけで、早速試してみようと思います。

参考にさせていただいたのはこちら

DeepSeek R1をほぼ準備なしからローカルGPUで動かす

https://note.com/cppp_cpchan/n/n3c1039c80dd0

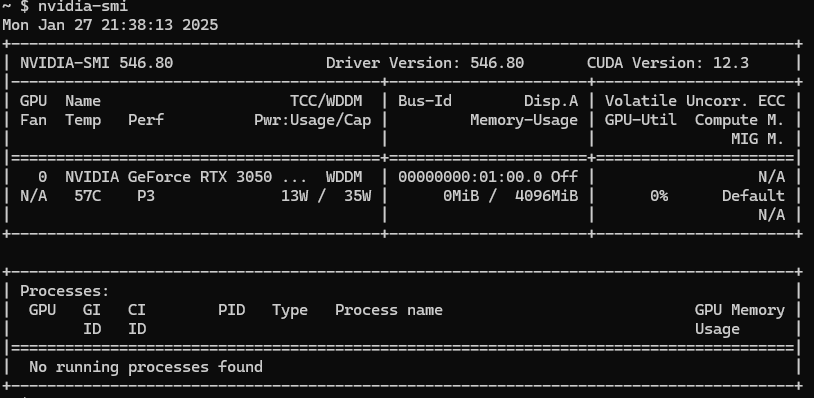

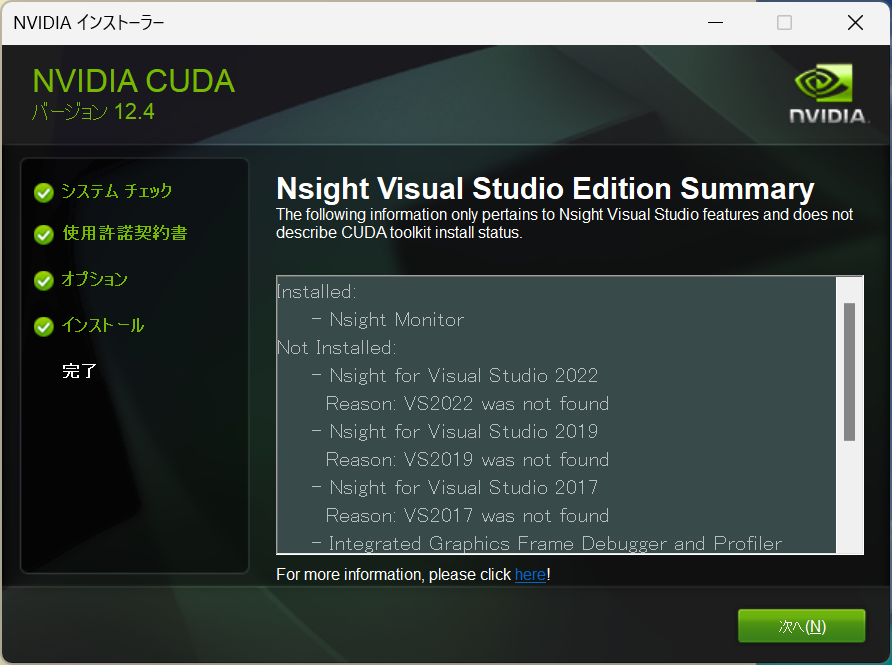

CUDAの確認

私の環境では、CUDAは12.3だった

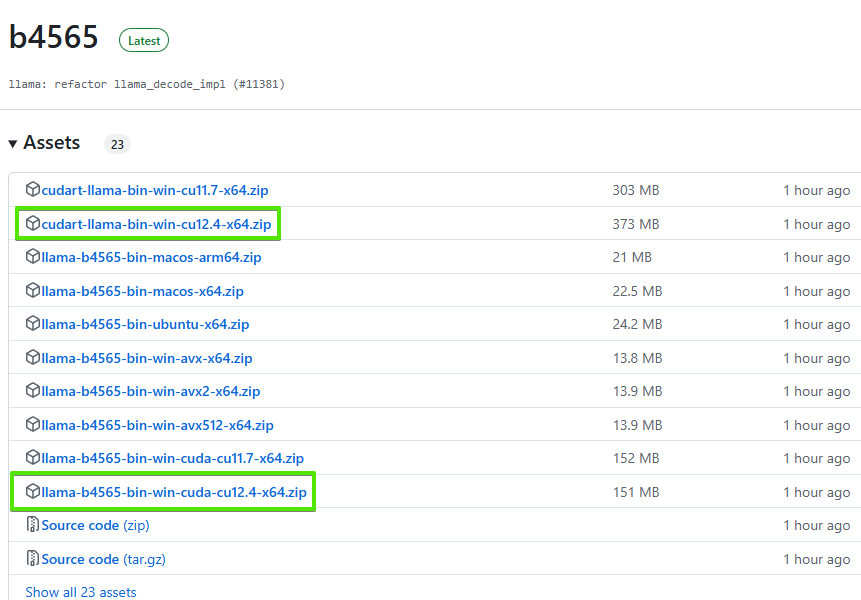

llama.cppをダウンロードしてくる。

https://github.com/ggerganov/llama.cpp/releases

見る限り、この2つなのだが、ローカルがCUDA 12.3で行けるものなのか。

試してみてから考える

試してみた

common_init_from_params: setting dry_penalty_last_n to ctx_size = 4096

common_init_from_params: warming up the model with an empty run - please wait ... (--no-warmup to disable)

ggml_cuda_compute_forward: ADD failed

CUDA error: the provided PTX was compiled with an unsupported toolchain.

current device: 0, in function ggml_cuda_compute_forward at D:\a\llama.cpp\llama.cpp\ggml\src\ggml-cuda\ggml-cuda.cu:2230

err

D:\a\llama.cpp\llama.cpp\ggml\src\ggml-cuda\ggml-cuda.cu:71: CUDA error

sh: ./llama-server.exe: このアプリケーションで、スタック ベースのバッファーのオーバーランが検出されました。このオーバーラン により、悪質なユーザーがこのアプリケーションを制御できるようになる可能性があります。 Error 0xc0000409実行してみると、エラーとなってしまった。

エラーメッセージからは、「unsupported toolchain」ということで、12.3環境で12.4を動かしたことによるエラーではないかと推察する。

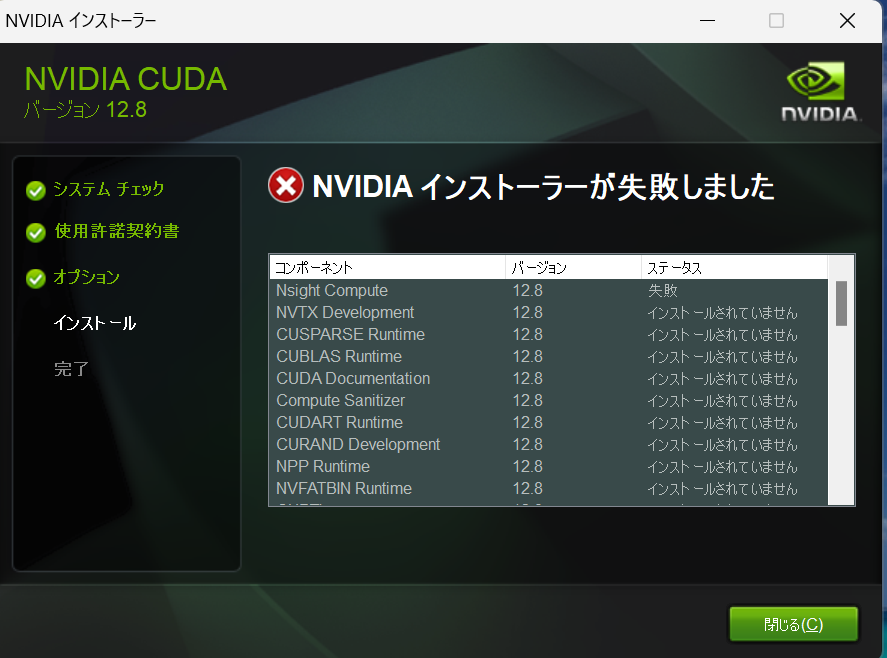

そこでCUDA 12.8(最新)を入れようとするもエラー・・・。

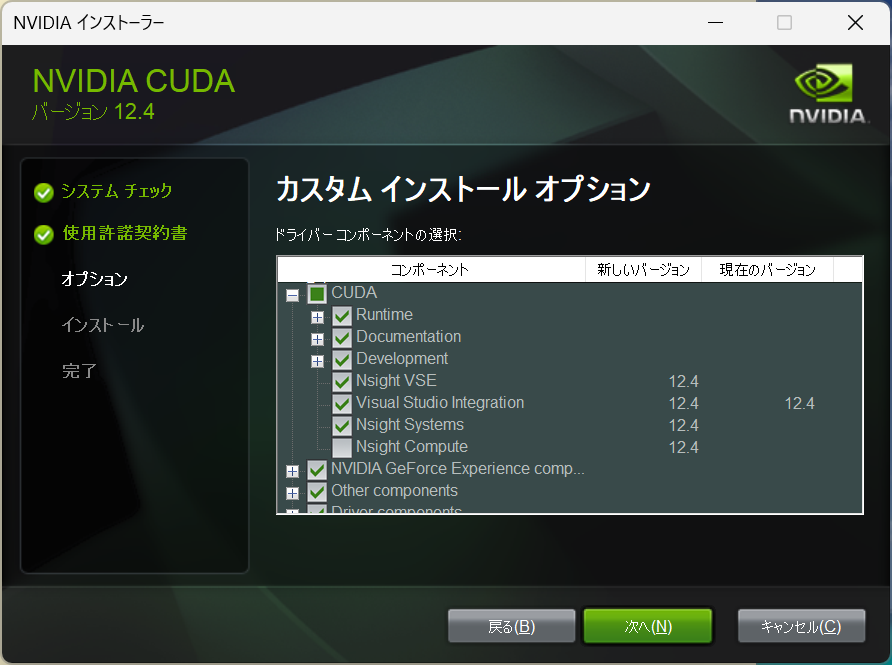

しょうがないので、llamaとバージョンを合わせた12.4を拾ってくる

CUDA Toolkit 12.4 Update 1 Downloads

https://developer.nvidia.com/cuda-12-4-1-download-archive?target_os=Windows&target_arch=x86_64&target_version=11&target_type=exe_local

同じエラーになった。。。

Nsight Coputeというものが原因のようだが、これは使わないっぽいのでカスタムインストールで設定を外してみる

とりあえずインストール出来たっぽい

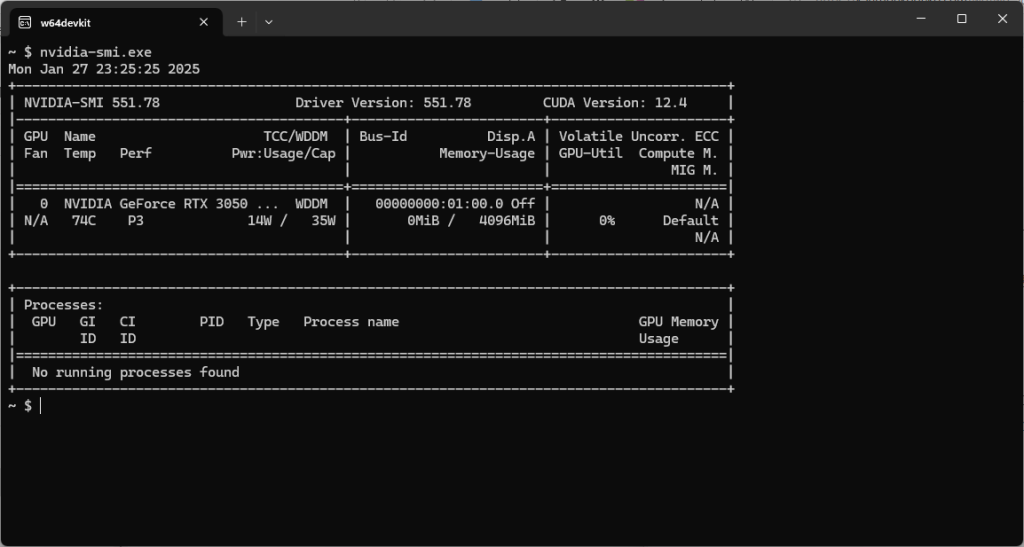

smiで確認してみると、ちゃんとバージョンが上がっている

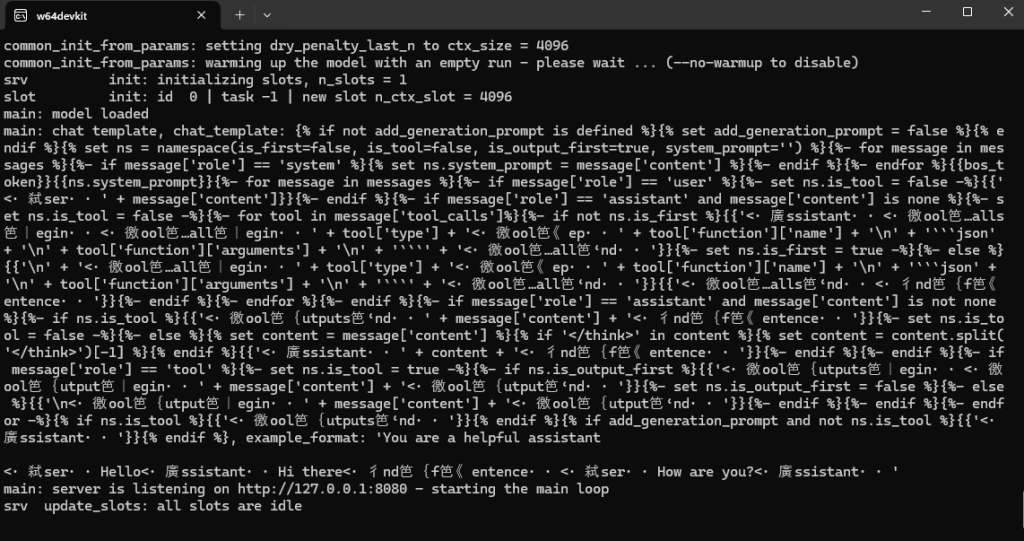

さて、実行です。

実行パラメータとしては以下を行っています

./llama-server.exe -m ../DeepSeek-R1-Distill-Qwen-14B-Q6_K.gguf -ngl 26 -b 2048 --temp 0.6

最初、nglの値を49にして実施してみたが、メモリが足りないというエラーとなってしまい、26でやるとエラーにならずに出来た。

このあたりのパラメータの加減は環境ごとに見極める必要がありそう。

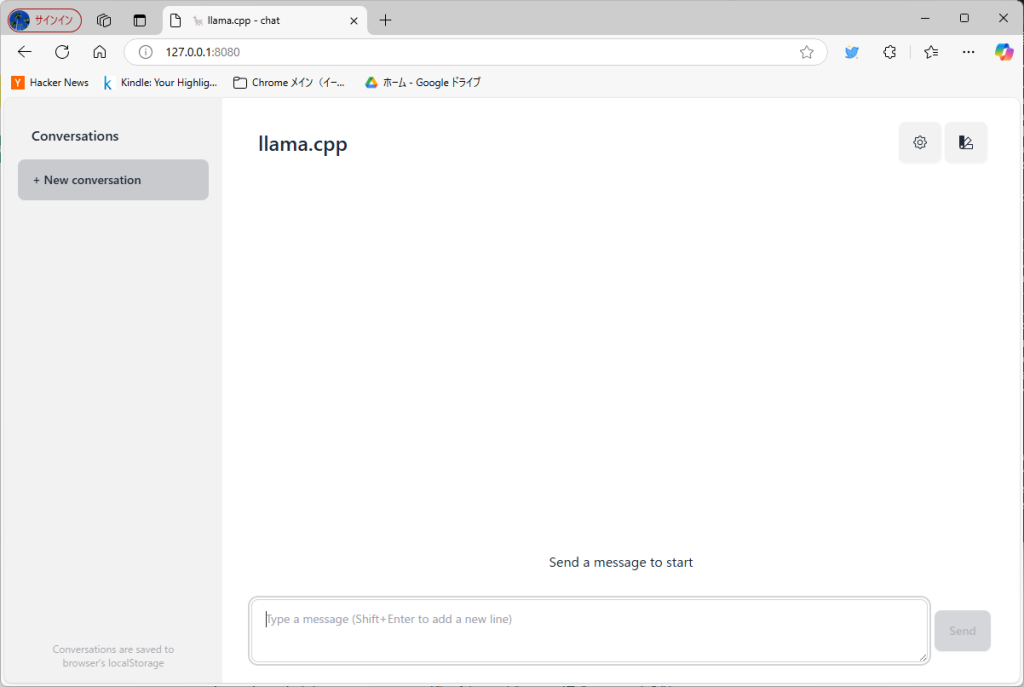

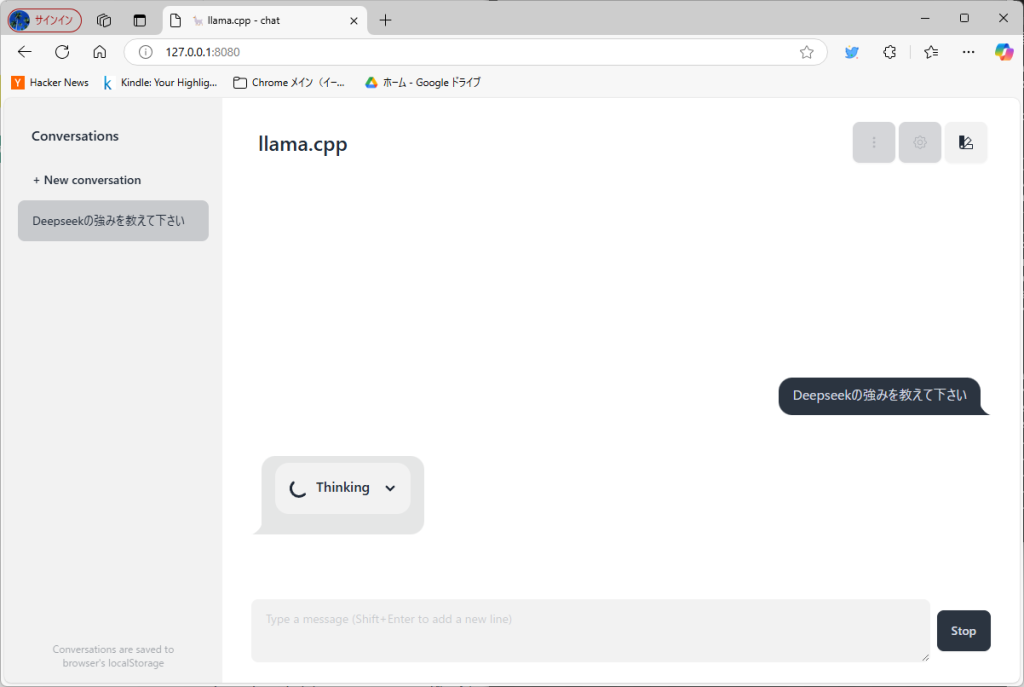

言われているURLへアクセスすると

それっぽい画面が出来ている!

早速問い合わせてみたのだが、「Thinking」からかなりの長時間が経過しているが変化ない

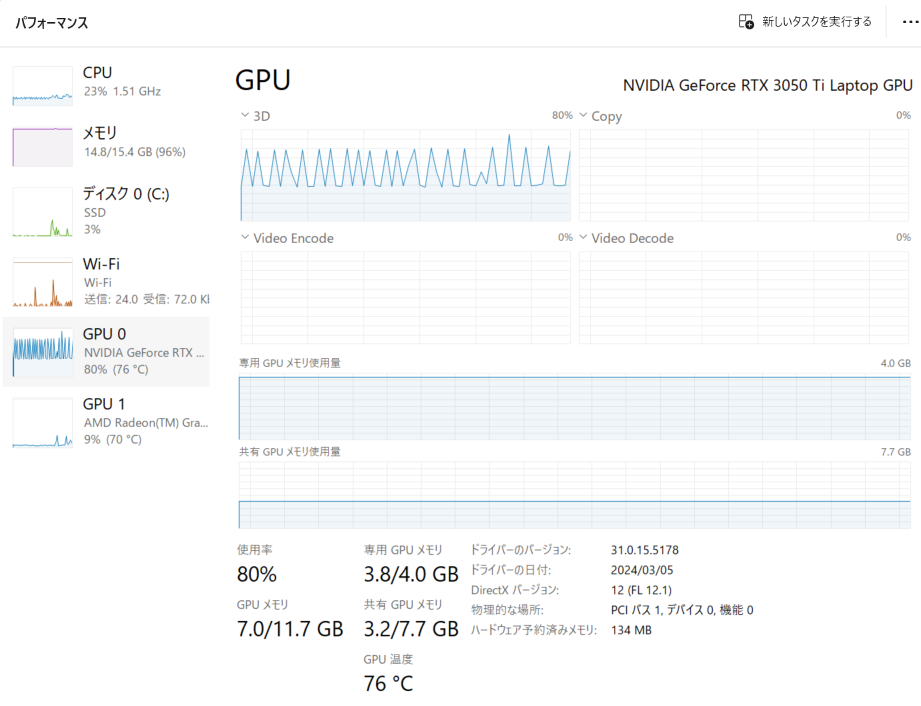

GPUのパフォーマンスをタスクマネージャで確認して見ると、「専有GPUメモリ使用量」は張り付いていて、「3D」となっているところはギザギザの波形が出ている。

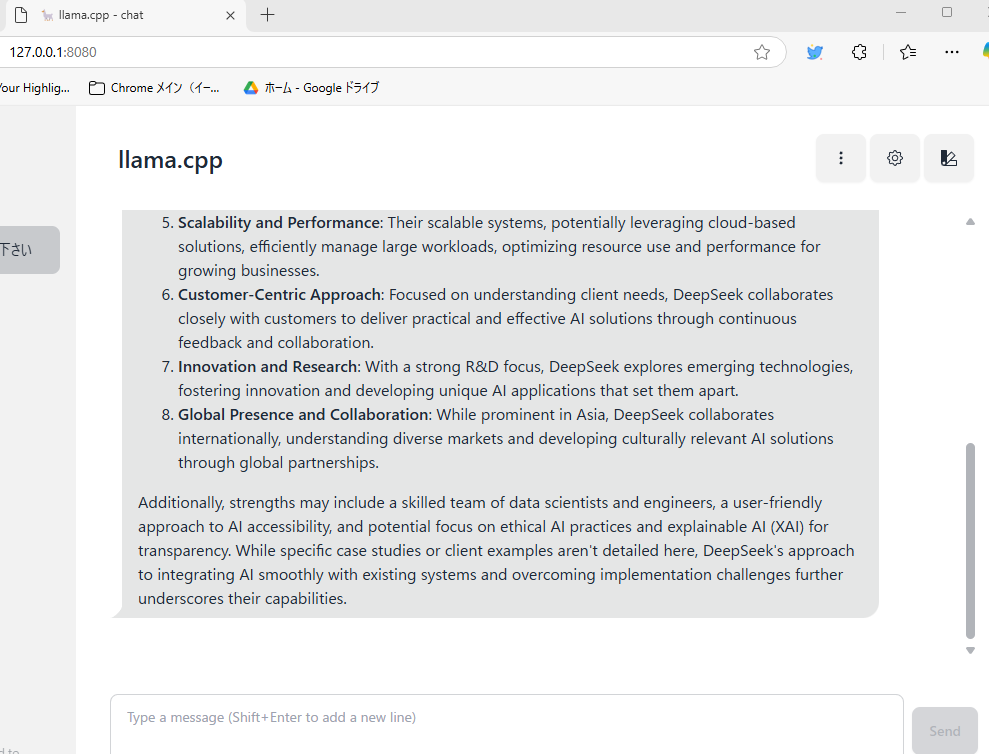

かなりの時間が経過した後に応答があった。

とりあえず、動くには動いたが、パフォーマンスはというとひどいものである。

パラメータを見直してなんとかなるものかはちょっとわからないが、試してみるだけ試してみようとは思う