先日購入したPanasonicのホームベーカリー。

大活躍しています。

パナソニック ホームベーカリー パン焼き器 2斤 40オートメニュー ホワイト SD-BMT2000-W

これまでも、基本となるパン(パン・ド・ミ)をベースにレーズンパン、クルミパン、全粒粉(50%, 10%)といろいろと挑戦してきました。

そして、正月は過ぎてしまいましたが新年ということで今回は餅に挑戦してみることに。

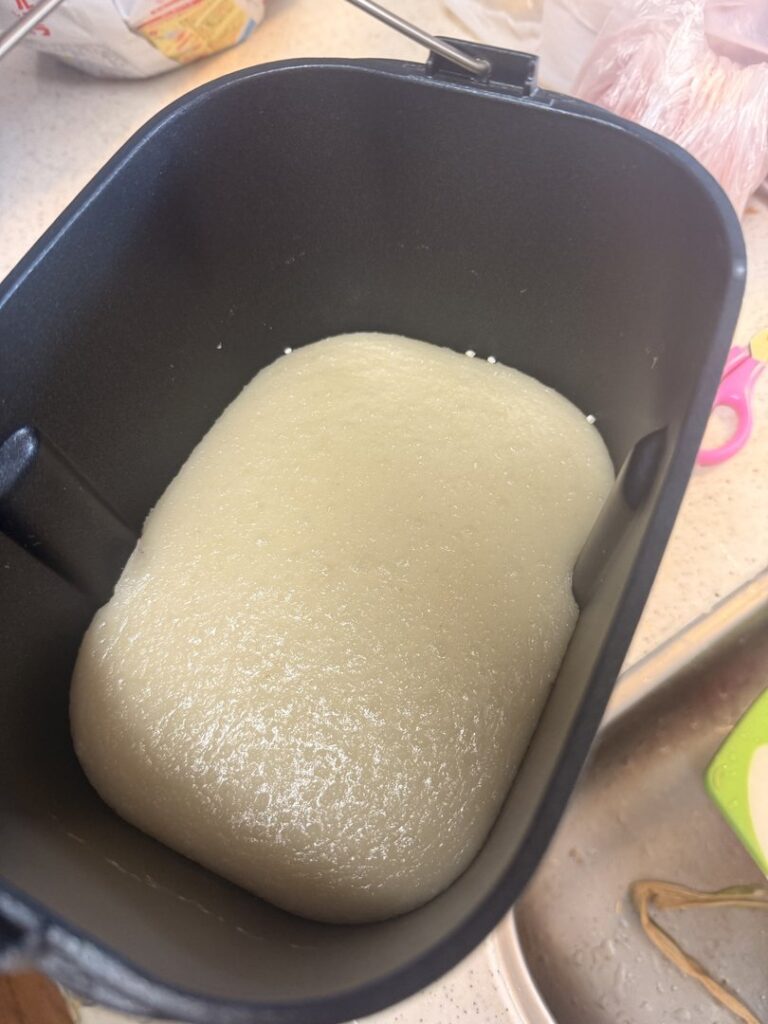

餅はレシピを見る限りではもち米を6合~入れることが出来る。

そして、もち米を給水させた後の重さを測って、規定の重さまで水を入れるというちょっと不思議な工程になっていました。

これは、もち米に寄って給水量の差が出るからだそうです。

計量してやるものの、パット見で水の量が少なく感じてしまい不安になりました。

あとは、もち米を炊くところからやってくれるので、材料をセットしてスイッチを置くだけ

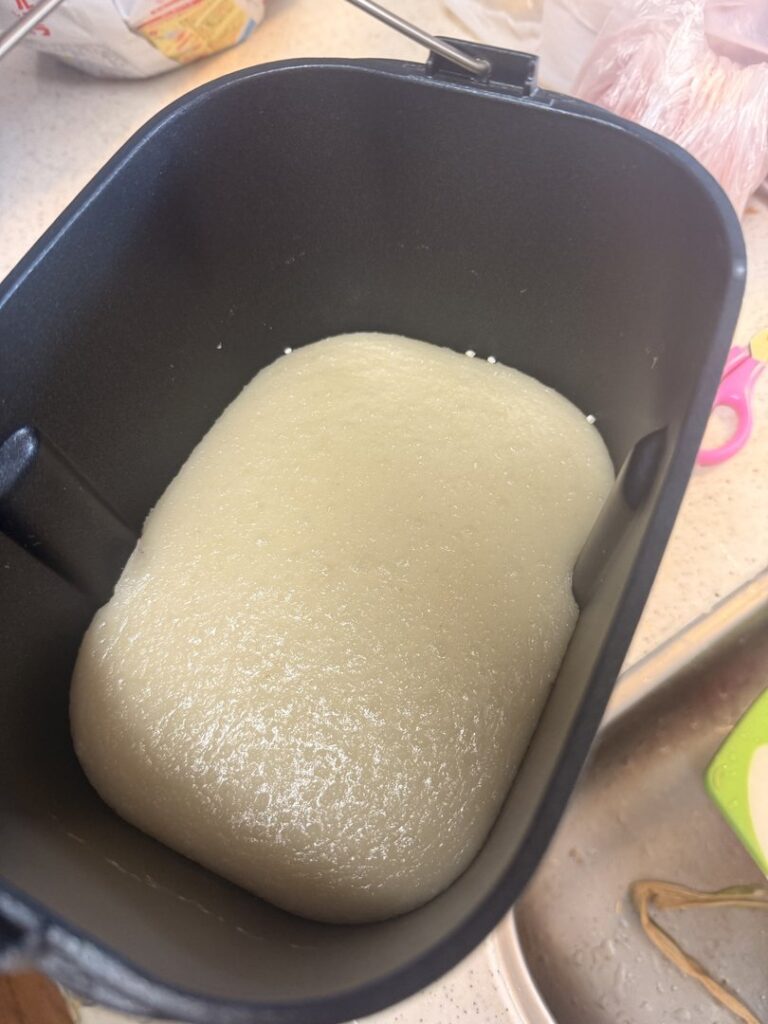

無事に餅ができ。。。た?

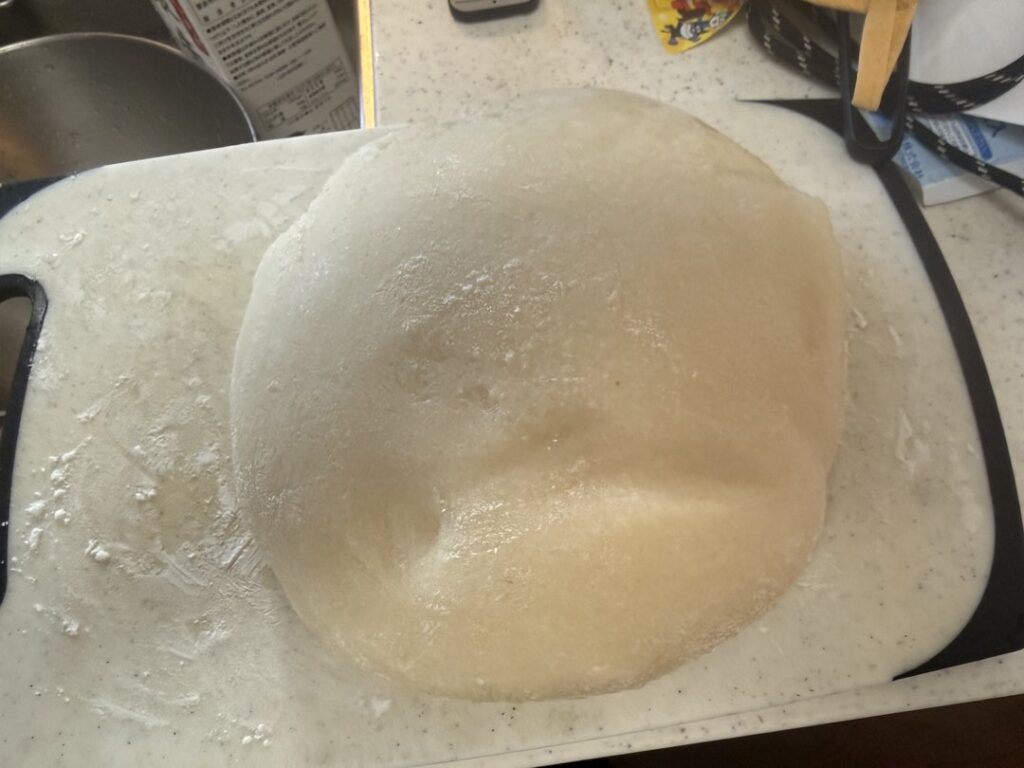

出来ました!

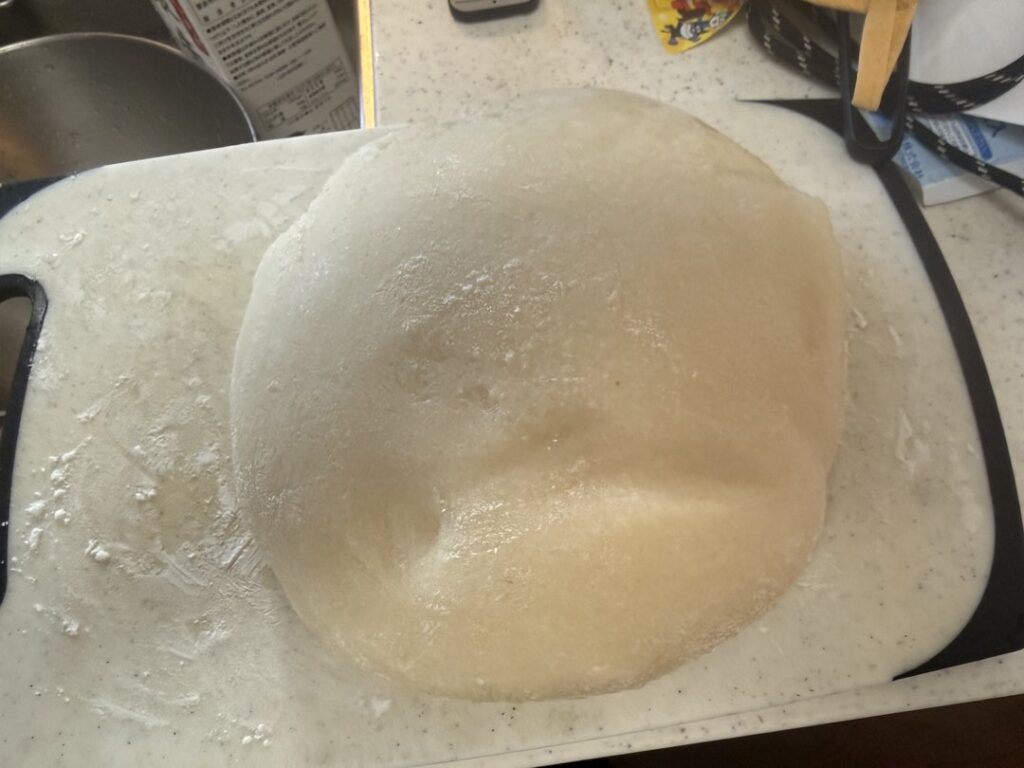

とりあえず餅とり粉として片栗粉を使って対応。

熱いのを我慢して小さく取り分けていただきました。

柔らかいお持ちを食べることが出来るのは、自宅でついたからこそですね。

とは言っても、やはりホームベーカリーでついたお餅なので、杵と臼でやるようなしっかりとしたお餅とは差が感じられます。

このあたりは、ついているというよりこねているのでしょうがないところでしょう。

また、ホームベーカリーが2斤用ということもあるのかわかりませんが、レシピの最小単位が6合。ちょっと多いです。

もう少し少ない量で作ることが出来ると手軽なんですけどね。

ボタン一つで出来るメニューはだいぶやってきたので、後はもう少し手の込んだ者への挑戦までするかですね~。

生地づくりまでやってもらって、そこからの工程を手動でやるレシピはそれなりにあるのですが、やはり手間になるのでちょっと尻込みしてしまいます。

というのも、そもそも挑戦するまでもなく普通のパンやレーズンパンが美味しいんですよね。特に不満がないので、これでいいじゃん、と。

餅は餅で、悪くはないのですがもち米はそれなりにお高いです。。

やはり普通のパンが一番な気がします!